- GPT-4 поддерживает ввод изображений и текста, в то время как GPT-3.5 принимает только текст.

- GPT-4 показал результаты, сравнимые с человеческими, в различных профессиональных и учебных тестах. Например, он сдал экзамен на адвоката, попав в 10% лучших тестируемых.

- OpenAI затратила 6 месяцев на тестирование и настройку GPT-4. В простом чате разница между GPT-3.5 и GPT-4 не так заметна, но на более сложных задачах она становится очевидной. GPT-4 более надежен и креативен, чем GPT-3.5, и может обрабатывать более сложные и запутанные запросы, а также сложные изображения. Однако, компания OpenAI признает, что GPT-4 не идеален, и в нем все еще есть проблемы с проверкой фактов, рассуждениями и чрезмерной самоуверенностью.

- Для использования новой версии Chat GPT-4 сейчас потребуется активная подписка на ChatGPT Plus ($20). Компания OpenAI планирует со временем ввести платную подписку для тех, кто пользуется системой в больших объемах, но надеется оставить несколько бесплатных запросов для обычных пользователей.

Возможности и примеры использования новой модели

За последние два года команда переработала весь стек глубокого обучения и в партнерстве с Azure создала суперкомпьютер с нуля. Год назад OpenAI обучил GPT-3.5 в качестве первого "тестового прогона" всей системы, в частности, было найдено и исправлено несколько ошибок и улучшена предыдущая база. В результате получился ChatGPT-4, который работает стабильно и стал первой крупной моделью, эффективность обучения которой можно точно предсказать заранее.

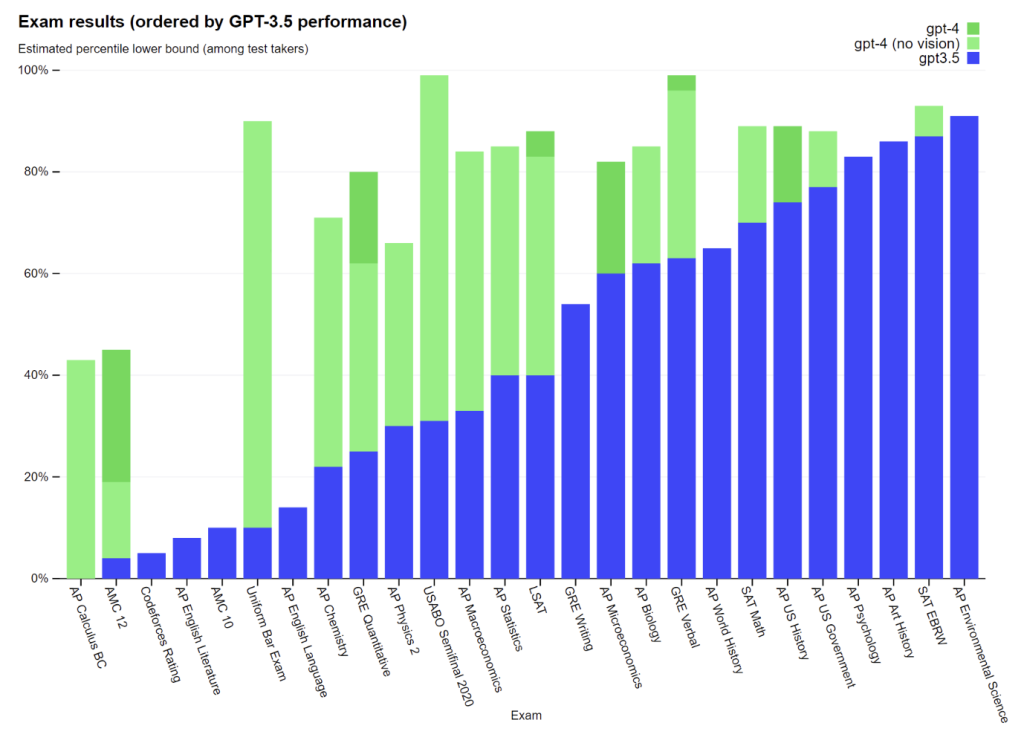

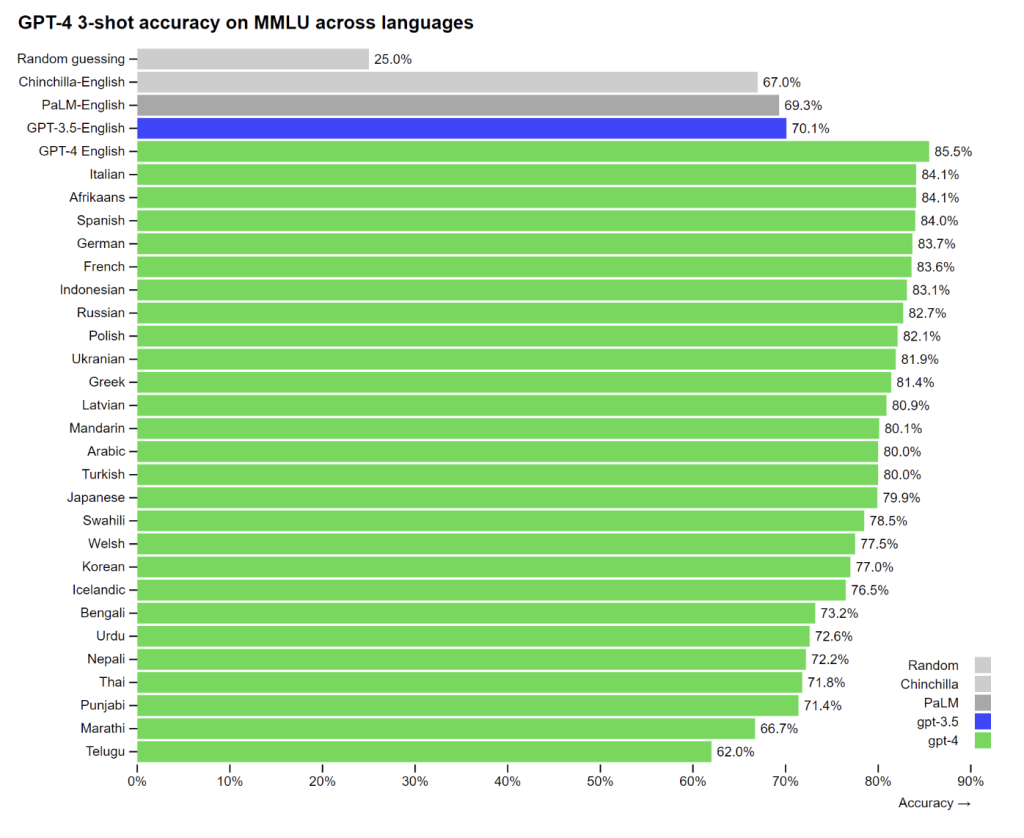

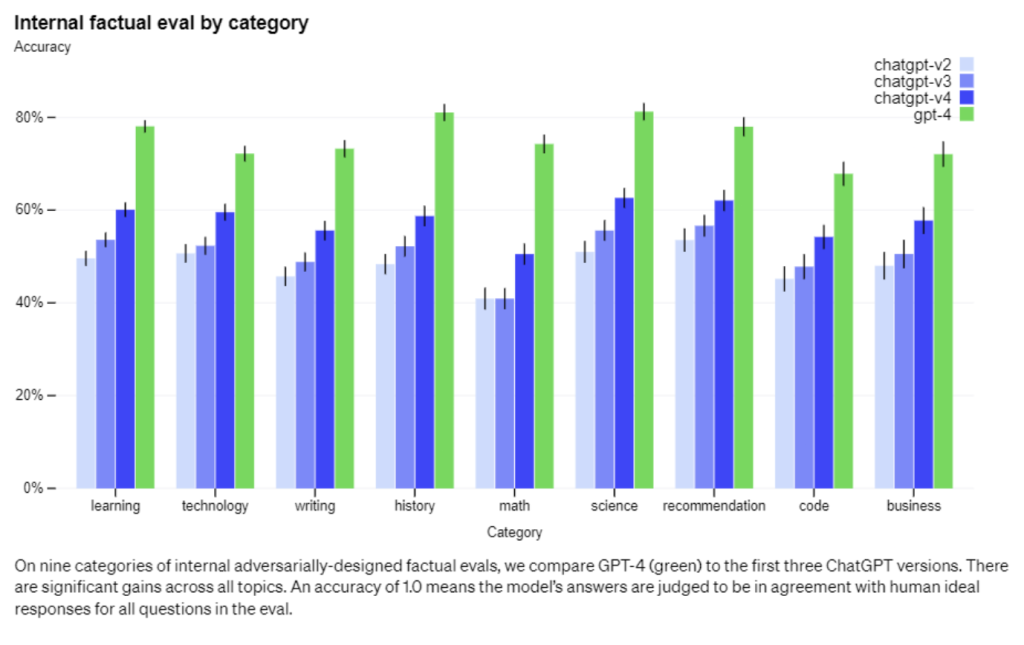

GPT-3.5 и GPT-4 в простых запросах различаются незначительно. Разница видна в сложных задачах, требующих креативного подхода, надежности и максимальной подробности ответа. Например, решение тестов и олимпиадных задач. Зелеными столбцами на графике обозначено насколько лучше справляется новая модель:

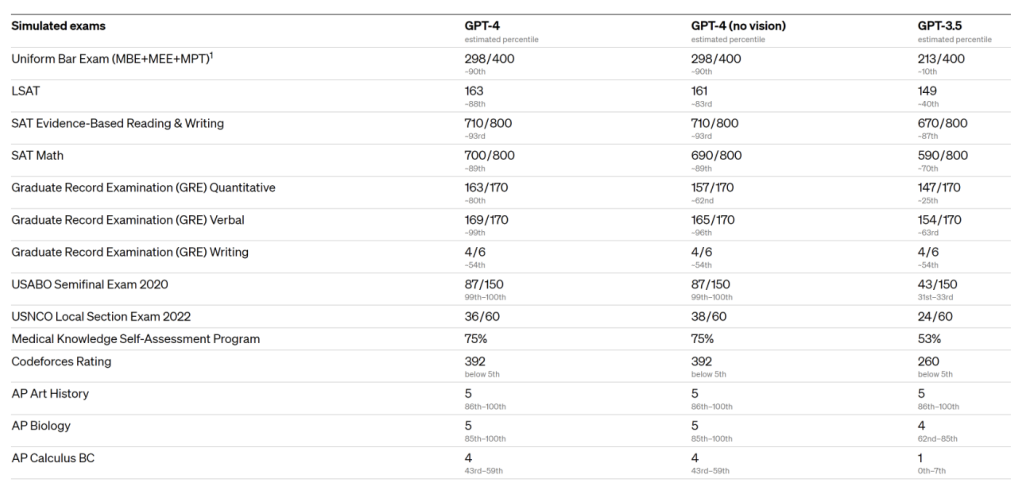

В таблице ниже приведены очки, которые GPT-4 набрала по различным американским тестам. Мелким шрифтом отмечено попадание в процент лучших. Особый интерес вызвала математическая секция экзамена SAT Math, в которую входят задачи по алгебре и геометрии, в том числе требующие теоретических знания о функциях множества и модуле числа, а также знания уравнений, содержащих радикалы, степени и функции. Chat GPT-4 получила 700 из 800 баллов и попала в топ 11% проходящих этот тест. Причем ИИ специально не тренировался выполнять тесты SAT:

Разработчики также проверили как ИИ справляется с разными языками. Они протестировали 26 языков. Английский, очевидно, стал самым понятным языком общения для ChatGPT с результатом 85.5%, на втором месте итальянский - 84.1%, русский получил относительный рейтинг в 82.7%, тайский - 71.8%, а язык Телугу (один из индийских языков) - 62% - минимум из протестированных:

Визуальный ввод

Chat GPT 4 теперь понимает не только текст, но и изображения: документы с текстом и фотографиями, диаграммы, скриншоты и многое другое.

На данной картинке ИИ правильно распознал, что провод зарядки для iPhone “стилизован” под старый VGA разъем, и что все это выглядит как “прикол для олдов”:

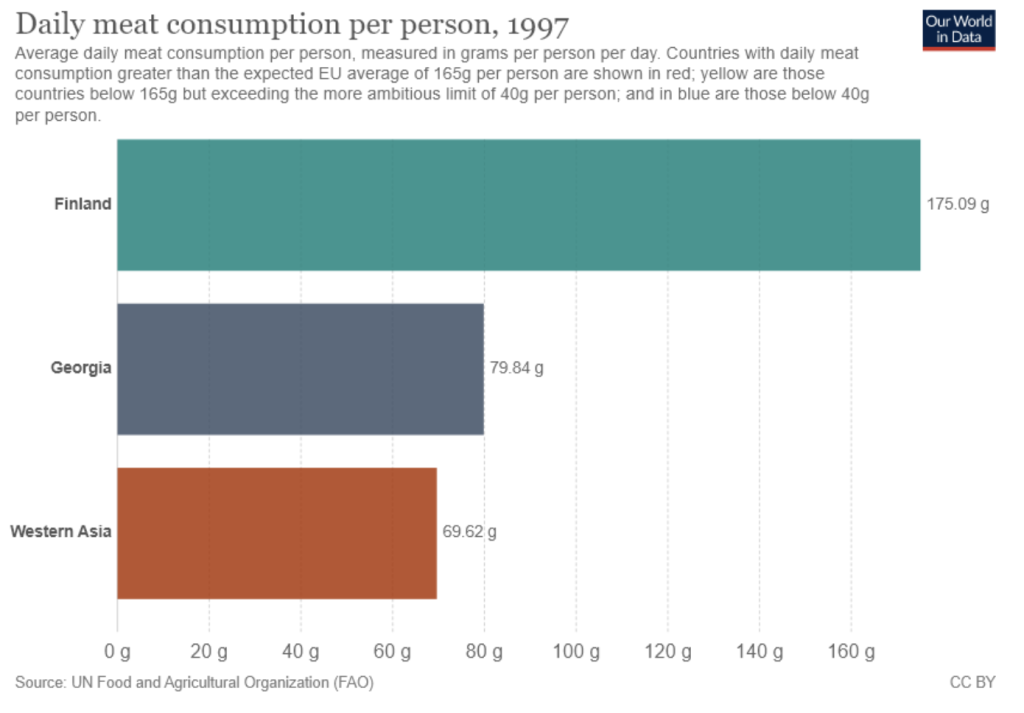

С данной картинки ИИ спокойно выделил данные и сложил потребление мяса в Грузии и Западной Азии:

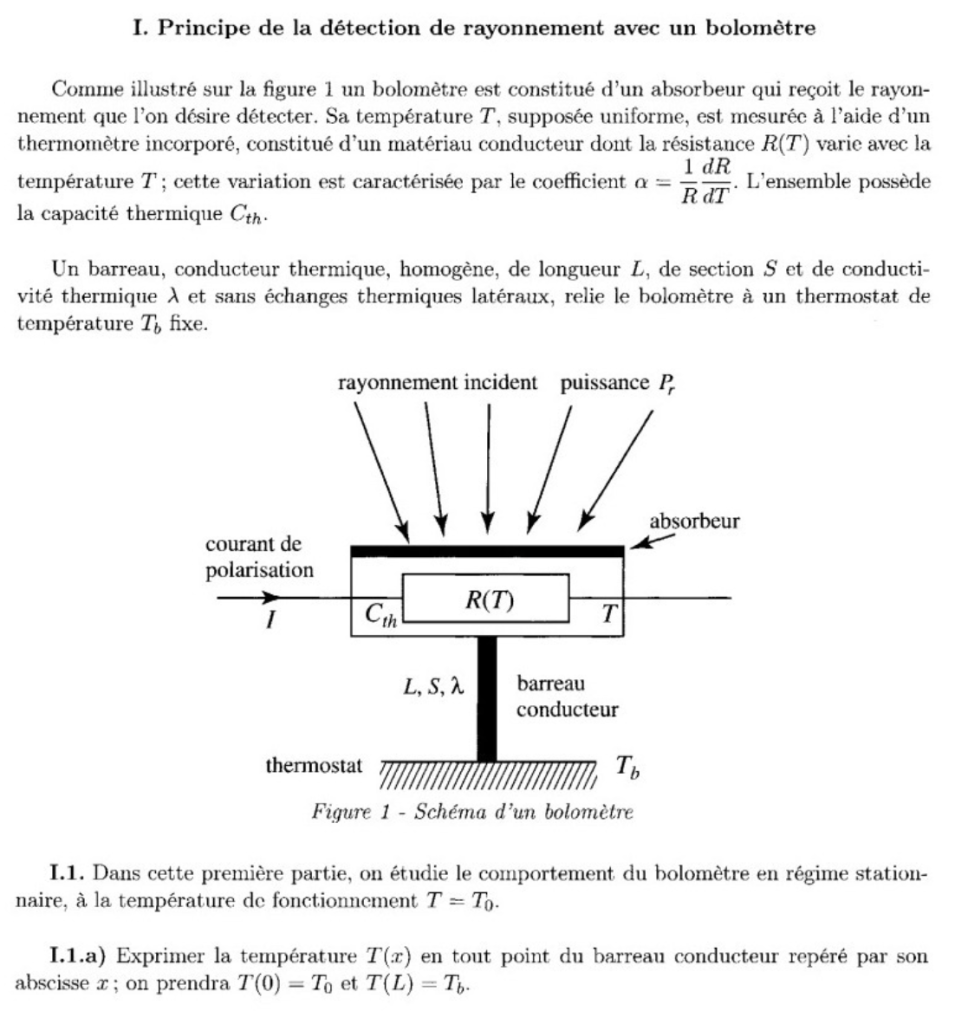

Также ИИ подробно решил и описал физическую задачу написанную на французском:

ИИ точно определил, что на данной картинке мужчина гладит белье на гладильной доске, закрепленной на машине:

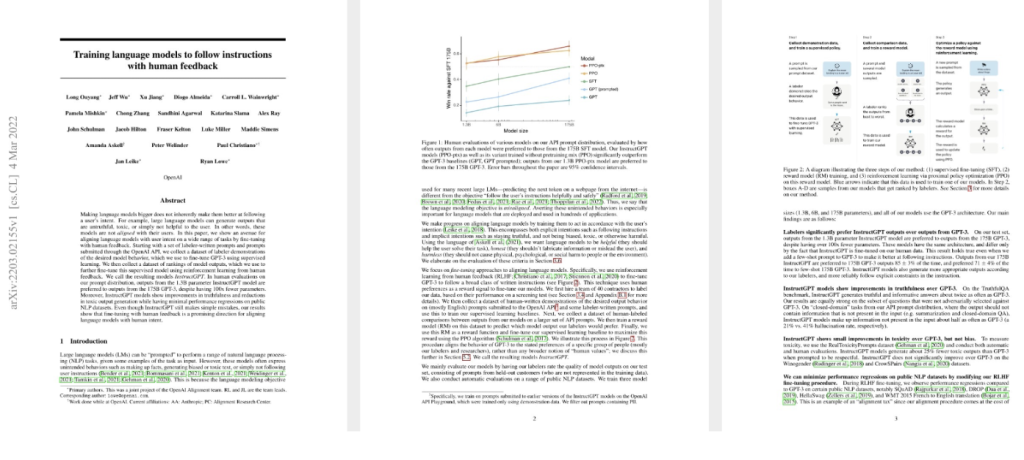

Сделал выжимку из сложной инструкции:

Объяснил мем, где земля собрана из запеченной курочки:

Управляемость

Вместо классической персонализации ChatGPT с фиксированным количеством слов, тоном, пользователи Chat GPT вскоре смогут настраивать стиль и задачи для своего ИИ, описывая эти предпочтения в «системном» сообщении. API системных сообщений позволят пользователям настроить интерфейс под свои предпочтения.

Ограничения

Chat GPT-4 имеет те же ограничения, что и предыдущие модели GPT. Она по-прежнему придумывает факты и допускает ошибки в рассуждениях. Текущая модель на 40% превосходит GPT-3.5 по внутренней оценке компании.

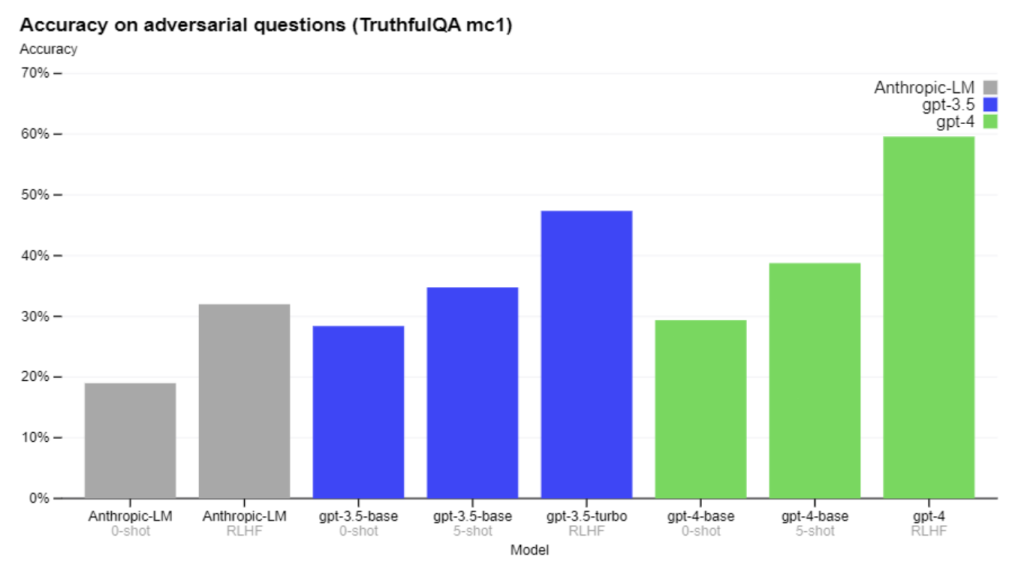

Есть прогресс при работе с внешними эталонами, такими как TruthfulQA, который проверяет способность модели отделять факты от набора неверных утверждений.

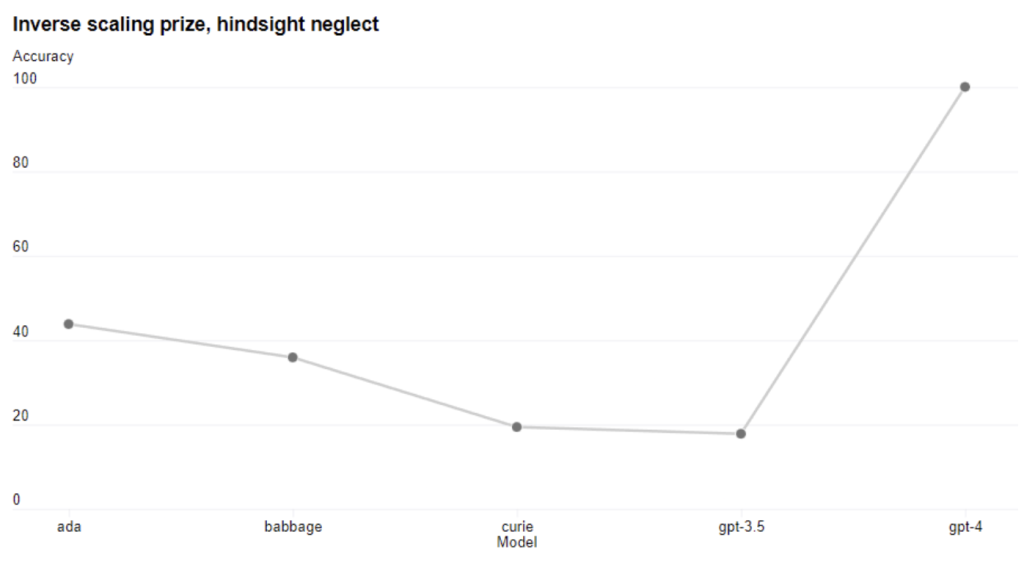

GPT-4 не знает о событиях, которые произошли после сентября 2021 года, и не учитывает их в своих выводах. Иногда он может допускать простые ошибки, которые не соответствуют его экспертизе в различных областях, быть слишком доверчивым к пользователям или не справляться с трудными задачами так же, как люди.

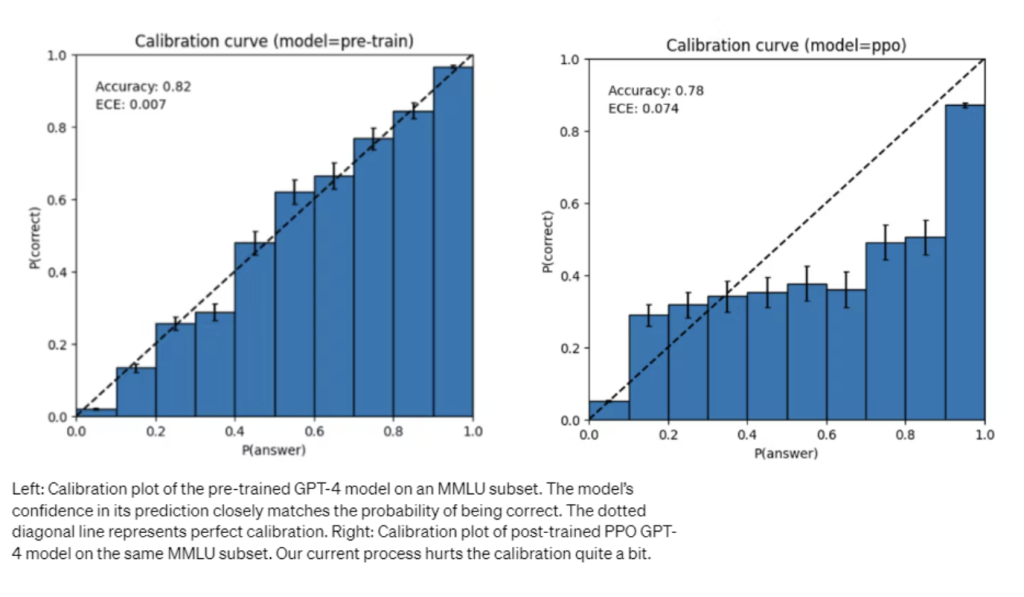

Также возможно, что Chat GPT-4 может ошибаться в своих прогнозах, не проверяя их правильность, когда есть вероятность ошибиться. Базовая модель хорошо калибруется (предсказанная вероятность правильного ответа совпадает с вероятностью правильного ответа), но текущий процесс обучения снижает ее калибровку.

Риски и меры по их снижению

Команда усиливает безопасность GPT-4 через отбор и фильтрацию данных перед обучением. Были наняты эксперты для тестирования запросов с высоким уровнем риска. Отзывы и данные от экспертов в этих областях использовались для улучшения модели. Например, команда работала над тем, чтобы Chat GPT-4 отклонял такие запросы как “синтезирование опасных химических веществ”.

По сравнению с GPT-3.5 разработчики снизили склонность GPT-4 отвечать на запросы о незаконном контенте на 82%, в то же время увеличив частоту ответов на конфиденциальные запросы (такие как медицинская консультация и причинение себе вреда) в соответствии с политикой OpenAI на 29%.

В целом, вмешательства команды снизили опасные запросы, но все еще существуют ситуации, когда пользователи ломают алгоритм и получают доступ к опасному контенту. Поскольку риски, связанные с искусственным интеллектом, постоянно увеличиваются, становится необходимым достижение высокой степени надежности в таких ситуациях.

Вероятно, ChatGPT-4 и последующие модели будут оказывать как положительное, так и отрицательное воздействие на общество. Команда привлекает внешних исследователей, чтобы оценить потенциальное воздействие на данном этапе и в будущем.

Процесс обучения

Аналогично старым версиям, GPT-4 обучена предсказывать следующее слово в документе и обучается на общедоступных данных. Когда пользователь задает вопрос, базовая модель может ответить на него различными способами, которые могут быть далеки от того, что задумал пользователь. Базируясь на общении с обратной связью, алгоритм подстраивается под пользователя. Однако способности модели обусловлены её предварительным обучением, а не обратной связью с пользователем.

Предсказуемое масштабирование

В ChatGPT-4 сделан акцент на создании масштабируемого стека глубокого обучения. Команда разработала инфраструктуру и оптимизацию, которые имеют предсказуемое поведение в разных масштабах. Кроме того, они начали разрабатывать методологию для предсказания более интерпретируемых метрик. Например, они успешно предсказали процент сдачи экзамена на подмножестве набора данных HumanEval, экстраполируя результаты моделей с в 1000 раз меньшим объемом вычислений:

Команда считает, что прогнозирование будущих возможностей машинного обучения - это важно для безопасности, и они наращивают свои усилия в этом направлении.

Программа оценки новых версий OpenAI

Команда OpenAI создала OpenAI Evals - программу для тестирования моделей типа GPT-4. Она используется для улучшения моделей и отслеживания их производительности (как для выявления недостатков, так и для предотвращения регресса), а пользователи могут применять ее для отслеживания производительности различных версий моделей (которые теперь будут выходить регулярно). Компания Stripe уже использовала Evals для оценки точности своего инструмента документирования на базе GPT.

Поскольку весь код является открытым, Evals поддерживает написание новых классов для реализации пользовательской логики оценки. Команда возлагает надежды, что Evals станет средством обмена и краудсорсинга эталонных шаблонов оценки. Наиболее полезные шаблоны будут включены для всех пользователей платформы.

API

Чтобы получить доступ к API GPT-4 (используется тот же ChatCompletions, что и gpt-3.5-turbo) необходимо зарегистрироваться в списке ожидания.